Beliebte Alltagsgeräte wie Fernseher sind immer häufiger mit dem Internet verbunden oder verfügen über internetbasierte Zusatzdienste. Die dabei entstehenden Daten über das Nutzerverhalten, ihre Weitergabe und Verarbeitung sowie die zunehmende Komplexität „smarter“ Technologien stellen den Schutz der Privatheit und die informationelle Selbstbestimmung vor neue Herausforderungen. Im White Paper „Verstecktes Internet“ skizzieren die Expertinnen und Experten des Forschungsverbunds „Forum Privatheit und selbstbestimmtes Leben in der digitalen Welt“ die aus Sicht des Privatheitsschutzes problematischen Aspekte smarter Technologien und zeigen mögliche Gestaltungspotenziale auf. Das White Paper konzentriert sich dabei auf die drei Anwendungsbereiche Smart TV, intelligente Autos sowie neue Endgeräte wie Smart Watches, die direkt am Körper getragen werden.

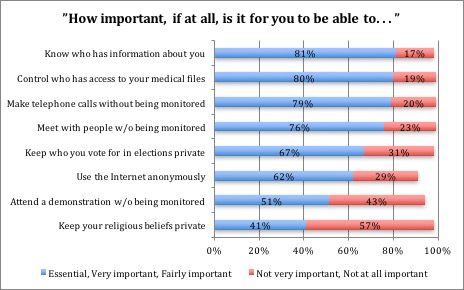

Vernetzte Smart TVs oder intelligente Armbänder, die über das „Internet der Dinge“ mit anderen Geräten, Dienstleistern und Herstellern verbunden sind, durchdringen zusehends den Alltag vieler Menschen. Die Nutzer schätzen besonders die netzbasierten Dienste und Funktionen dieser „smarten“ Geräte – ihnen ist jedoch häufig nicht bewusst, in welchem Umfang Nutzerdaten erhoben und zu welchen Zwecken sie weitergeleitet werden. Diese Probleme verschärfen sich mit der zunehmenden Komplexität smarter Technologien und es ist für die Nutzer kaum mehr nachzuvollziehen, ob und wie sich personenbezogene Daten vor ungewollten Zugriffen und Weitergaben schützen lassen.

Vor dem Hintergrund dieser veränderten Rahmenbedingungen für den Privatheits- und Datenschutz beschreibt der Forschungsverbund „Forum Privatheit“ im White Paper „Verstecktes Internet“ die Risiken, die bei der Nutzung von „Smart TVs“, „Smart Cars“ und „Wearables“ entstehen können: So erheben etwa Smart TVs schon beim gewöhnlichen Fernsehen Nutzungs- und Verhaltensdaten und ermöglichen über Foto-, Audio- und Videoaufnahmen sogar eine persönliche Identifikation. Dadurch lassen sich nicht nur Einzelpersonen sondern auch große Teile der Bevölkerung überwachen. All dies trifft in ähnlicher Weise auf vernetzte Autos bzw. „Smart Cars“ zu, die fahrzeugbezogene Daten, das Verhalten des Fahrers sowie Umgebungsdaten erfassen und diese an Fahrzeughersteller oder andere Verkehrsteilnehmer weiterleiten können. Neben Informationen über Fahrstil, Aufenthaltsort oder Fahrstrecke ließen sich durch die Verknüpfung mit anderen Daten zudem persönliche Merkmale und Gewohnheiten der Nutzer ableiten. Dies ist auch bei sogenannten „Wearables“ der Fall, also Geräten wie intelligenten Fitnessarmbändern oder Smart Watches, die Nutzer direkt am Körper tragen. Durch die Erhebung von Gesundheitsdaten werden zum Beispiel tiefe Einblicke in die privaten Lebensumstände der Nutzer erfasst.

Peter Zoche, der am Fraunhofer ISI die Forschungsaktivitäten des Forum Privatheit koordiniert, nennt an Hersteller, Nutzer und die Politik gerichtet einige zentrale Problembereiche und Gestaltungspotenziale: „Der Forderung nach informationeller Selbstbestimmung stehen ein intransparenter Datenhandel und versteckt erfolgende Datenerhebungen gegenüber. Hinzu kommt, sich die Grundeinstellung smarter Geräte oft nur bedingt verändern lässt. Und wenn Nutzer aktiv werden möchten, um selbst für mehr Datenschutz zu sorgen, sehen sie sich mit einer Informationsflut und komplexen Geschäftsbedingungen konfrontiert.“ Laut Zoche sollten vernetzte Geräte und Anwendungen in Zukunft über datenschutzfreundliche Grundkonfigurationen (Privacy by Default) verfügen und Nutzer durch visuelle oder akustische Hinweise auf mögliche Datentransfers hingewiesen und ihre Informationsbedarfe hierbei berücksichtigt werden.

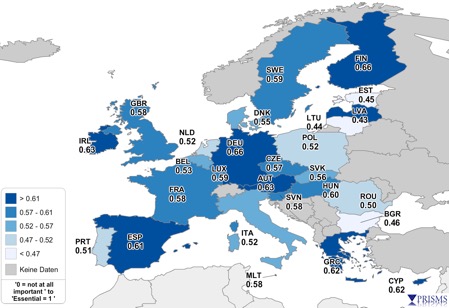

Des Weiteren sollten in Zukunft auch Möglichkeiten der politisch-rechtlichen Regulierung dafür sorgen, dass smarte Technologien stärker in Einklang mit den Prinzipien des Datenschutzes stehen. Sanktionsmöglichkeiten könnten genauso wie die Durchsetzung einer EU-weiten Datenschutz-Grundverordnung geeignete Voraussetzungen zur Gewährleistung von Privatheit im digitalen Zeitalter schaffen. Neben staatlichen Institutionen und Initiativen müssen jedoch auch wirtschaftliche Akteure dazu beitragen, dass Datenschutz zu einem Kernelement bei der Einführung neuer smarter Geräte und Anwendungen wird (Privacy by Design). Nicht zuletzt sind auch die Nutzer gefragt, künftig noch bewusster mit ihren persönlichen Daten sowie den damit verbundenen Risiken umzugehen.

Das White Paper kann hier heruntergeladen werden.